Computação Distribuída com TORQUE Resource Manager

O TORQUE Resource Manager fornece controle sobre trabalhos de grupo e recursos de computação distribuída. É um produto Open Source avançado, baseado no projeto original PBS e incorpora o melhor da comunidade e do desenvolvimento profissional. Ele está atualmente em uso em dezenas de milhares de aplicações governamentais, acadêmicas e sites comerciais em todo o mundo.

[ Hits: 23.205 ]

Por: Juno Kim em 28/08/2013 | Blog: http://www.kim.eti.br

Testes dos cluster

# pbsnodes -a

cc-vol01

state = free

np = 8

ntype = cluster

status = rectime=1377278496,varattr=,jobs=,state=free,netload=14836207715,gres=,

loadave=0.00,ncpus=8,physmem=16385144kb,

availmem=46749604kb,totmem=47634548kb,idletime=357091,nusers=0,nsessions=0,uname=Linux cc-vol01 3.2.0-4-amd64

#1 SMP Debian 3.2.46-1 x86_64,opsys=linux

mom_service_port = 15002

mom_manager_port = 15003

cc-vol02

state = free

np = 8

ntype = cluster

status = rectime=1377278500,varattr=,jobs=,state=free,netload=12929673891,gres=,

loadave=0.00,ncpus=8,physmem=16383640kb,

availmem=46748096kb,totmem=47633044kb,idletime=357224,nusers=0,nsessions=0,uname=Linux cc-vol02 3.2.0-4-amd64

#1 SMP Debian 3.2.46-1 x86_64,opsys=linux

mom_service_port = 15002

mom_manager_port = 15003

Isso prova que nossos nós estão ativos e prontos.

Agora, vamos submeter alguns trabalhos (jobs) para o cluster:

# echo "sleep 30" | qsub -q batch@saturno

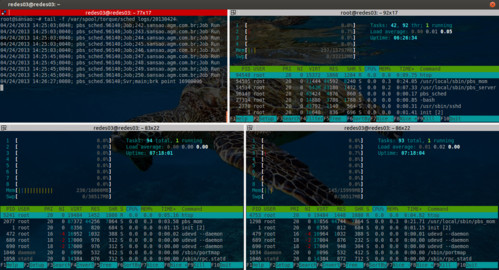

A imagem abaixo, mostra o processamento de alguns "jobs" processados pelos nós:

2. Instalação e configuração - I

3. Instalação e configuração - II

4. Testes dos cluster

5. Revisão

Configurando o proftpd com autenticação de usuário pelo passwd

Computação Distribuída com TORQUE Resource Manager - Parte 2

Falta de padronização no Linux

Instalação automatizada de servidores com Kickstart (parte 2)

Debian Lenny - DHCP3-server + Bind9 adicionando máquinas automaticamente

Instalando Debian através de um win32 executável

Muito interessante. Tenho total interesse em testar essa ferramenta. Parabens pelo artigo.

Interessante. Obrigado pelo artigo.

Em tempo, por que tanta memoria swap?

Olá amigo tobiasgnu,

O motivo de ter a memória extensa é para precaver os nós de travarem pois rodamos um programa de reconhecimento de fala que ocupa 100% da memória física em quanto carrega.

Olá, primeiramente, obrigado pelo tutorial, como sempre desse site, muito bem explicado e didático.

Instalei o toque no nosso cluster aqui, tal contendo 1 head node e 6 slaves. A instalação e configuração deu tudo certo, o pbsnodes -a mostra corretamente os nodos, em estado "free". Se submeto um submitionfile.sh com um comando básico, como por exemplo wget ou uma sequencia de locates, ele consegue escalonar o job, executa, ficando em R no qstat até acabar e finaliza... Mas quando submeto uma execução de um software que usamos aqui chamado Gromacs, que tem instalado em todos os slave nodes, ele vai para estado E e C no qstat, sem deixar nenhum log, erro, output, nada... Nem no "Torque/serv_logs"... Se executo o mesmo comando, localmente no nodo, sem usar o torque, ele executa e fica correto como precisava ser.

Alguém poderia me ajudar? Não forneci mais informações porque não sei nem achar qual é o erro.

Obrigado desde já!!!

Patrocínio

Destaques

Vou voltar moderar conteúdos de Dicas e Artigos (0)

Artigos

Compartilhando a tela do Computador no Celular via Deskreen

Como Configurar um Túnel SSH Reverso para Acessar Sua Máquina Local a Partir de uma Máquina Remota

Configuração para desligamento automatizado de Computadores em um Ambiente Comercial

Dicas

Como renomear arquivos de letras maiúsculas para minúsculas

Imprimindo no formato livreto no Linux

Vim - incrementando números em substituição

Efeito "livro" em arquivos PDF

Como resolver o erro no CUPS: Unable to get list of printer drivers

Tópicos

Instalação Uefi com o instalador clássico do Mageia (1)

Vou voltar moderar conteúdos de Dicas e Artigos (0)

Top 10 do mês

-

Xerxes

1° lugar - 67.004 pts -

Fábio Berbert de Paula

2° lugar - 50.958 pts -

Buckminster

3° lugar - 18.086 pts -

Mauricio Ferrari

4° lugar - 15.768 pts -

Alberto Federman Neto.

5° lugar - 14.428 pts -

Diego Mendes Rodrigues

6° lugar - 13.566 pts -

Daniel Lara Souza

7° lugar - 12.850 pts -

edps

8° lugar - 11.226 pts -

Andre (pinduvoz)

9° lugar - 11.024 pts -

Alessandro de Oliveira Faria (A.K.A. CABELO)

10° lugar - 10.961 pts

Scripts

[Python] Automação de scan de vulnerabilidades

[Python] Script para analise de superficie de ataque

[Shell Script] Novo script para redimensionar, rotacionar, converter e espelhar arquivos de imagem

[Shell Script] Iniciador de DOOM (DSDA-DOOM, Doom Retro ou Woof!)

[Shell Script] Script para adicionar bordas às imagens de uma pasta